如何使用聊天模型调用工具

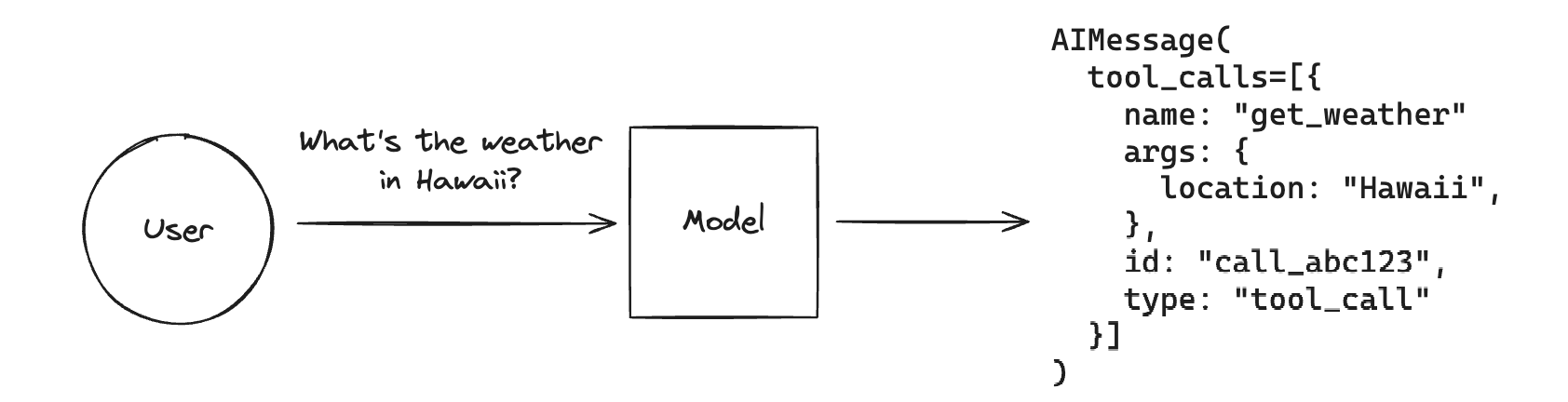

工具调用 允许聊天模型通过“调用工具”来响应给定提示。

请记住,虽然“工具调用”这个名称暗示模型正在直接执行某些操作,但实际上并非如此!模型仅生成工具的参数,而实际运行工具(或不运行)则由用户决定。

工具调用是一种生成模型结构化输出的通用技术,即使您不打算调用任何工具,也可以使用它。一个示例用例是从非结构化文本中提取。

如果您想了解如何使用模型生成的工具调用来实际运行工具,请查看本指南。

工具调用并非普遍适用,但许多流行的 LLM 提供商都支持它。您可以在此处找到所有支持工具调用的模型列表。

LangChain 实现定义工具、将工具传递给 LLM 以及表示工具调用的标准接口。本指南将介绍如何将工具绑定到 LLM,然后调用 LLM 生成这些参数。

定义工具模式

为了使模型能够调用工具,我们需要传入描述工具的功能及其参数的工具模式。支持工具调用功能的聊天模型实现了 .bind_tools() 方法,用于将工具模式传递给模型。工具模式可以作为 Python 函数(带有类型提示和文档字符串)、Pydantic 模型、TypedDict 类或 LangChain 工具对象 传入。模型的后续调用将传入这些工具模式以及提示。

Python 函数

我们的工具模式可以是 Python 函数。

# The function name, type hints, and docstring are all part of the tool

# schema that's passed to the model. Defining good, descriptive schemas

# is an extension of prompt engineering and is an important part of

# getting models to perform well.

def add(a: int, b: int) -> int:

"""Add two integers.

Args:

a: First integer

b: Second integer

"""

return a + b

def multiply(a: int, b: int) -> int:

"""Multiply two integers.

Args:

a: First integer

b: Second integer

"""

return a * b

LangChain 工具

LangChain 还实现了一个 @tool 装饰器,允许进一步控制工具模式,例如工具名称和参数描述。有关详细信息,请参阅以下操作指南 此处。

Pydantic 类

您可以使用 Pydantic 等效地定义模式,而无需随附的函数。

请注意,除非提供默认值,否则所有字段都是 required。

from langchain_core.pydantic_v1 import BaseModel, Field

class add(BaseModel):

"""Add two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

class multiply(BaseModel):

"""Multiply two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

TypedDict 类

langchain-core>=0.2.25或者使用 TypedDicts 和注解

from typing_extensions import Annotated, TypedDict

class add(TypedDict):

"""Add two integers."""

# Annotations must have the type and can optionally include a default value and description (in that order).

a: Annotated[int, ..., "First integer"]

b: Annotated[int, ..., "Second integer"]

class multiply(BaseModel):

"""Multiply two integers."""

a: Annotated[int, ..., "First integer"]

b: Annotated[int, ..., "Second integer"]

tools = [add, multiply]

要将这些模式实际绑定到聊天模型,我们将使用 .bind_tools() 方法。这将处理将 add 和 multiply 模式转换为模型的正确格式。然后,每次调用模型时都会传入工具模式。

- OpenAI

- Anthropic

- Azure

- Cohere

- NVIDIA

- FireworksAI

- Groq

- MistralAI

- TogetherAI

pip install -qU langchain-openai

import getpass

import os

os.environ["OPENAI_API_KEY"] = getpass.getpass()

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(model="gpt-4o-mini")

pip install -qU langchain-anthropic

import getpass

import os

os.environ["ANTHROPIC_API_KEY"] = getpass.getpass()

from langchain_anthropic import ChatAnthropic

llm = ChatAnthropic(model="claude-3-5-sonnet-20240620")

pip install -qU langchain-openai

import getpass

import os

os.environ["AZURE_OPENAI_API_KEY"] = getpass.getpass()

from langchain_openai import AzureChatOpenAI

llm = AzureChatOpenAI(

azure_endpoint=os.environ["AZURE_OPENAI_ENDPOINT"],

azure_deployment=os.environ["AZURE_OPENAI_DEPLOYMENT_NAME"],

openai_api_version=os.environ["AZURE_OPENAI_API_VERSION"],

)

pip install -qU langchain-google-vertexai

import getpass

import os

os.environ["GOOGLE_API_KEY"] = getpass.getpass()

from langchain_google_vertexai import ChatVertexAI

llm = ChatVertexAI(model="gemini-1.5-flash")

pip install -qU langchain-cohere

import getpass

import os

os.environ["COHERE_API_KEY"] = getpass.getpass()

from langchain_cohere import ChatCohere

llm = ChatCohere(model="command-r-plus")

pip install -qU langchain-nvidia-ai-endpoints

import getpass

import os

os.environ["NVIDIA_API_KEY"] = getpass.getpass()

from langchain import ChatNVIDIA

llm = ChatNVIDIA(model="meta/llama3-70b-instruct")

pip install -qU langchain-fireworks

import getpass

import os

os.environ["FIREWORKS_API_KEY"] = getpass.getpass()

from langchain_fireworks import ChatFireworks

llm = ChatFireworks(model="accounts/fireworks/models/firefunction-v1", temperature=0)

pip install -qU langchain-groq

import getpass

import os

os.environ["GROQ_API_KEY"] = getpass.getpass()

from langchain_groq import ChatGroq

llm = ChatGroq(model="llama3-8b-8192")

pip install -qU langchain-mistralai

import getpass

import os

os.environ["MISTRAL_API_KEY"] = getpass.getpass()

from langchain_mistralai import ChatMistralAI

llm = ChatMistralAI(model="mistral-large-latest")

pip install -qU langchain-openai

import getpass

import os

os.environ["TOGETHER_API_KEY"] = getpass.getpass()

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(

base_url="https://api.together.xyz/v1",

api_key=os.environ["TOGETHER_API_KEY"],

model="mistralai/Mixtral-8x7B-Instruct-v0.1",

)

llm_with_tools = llm.bind_tools(tools)

query = "What is 3 * 12?"

llm_with_tools.invoke(query)

AIMessage(content='', additional_kwargs={'tool_calls': [{'id': 'call_BwYJ4UgU5pRVCBOUmiu7NhF9', 'function': {'arguments': '{"a":3,"b":12}', 'name': 'multiply'}, 'type': 'function'}]}, response_metadata={'token_usage': {'completion_tokens': 17, 'prompt_tokens': 80, 'total_tokens': 97}, 'model_name': 'gpt-4o-mini-2024-07-18', 'system_fingerprint': 'fp_ba606877f9', 'finish_reason': 'tool_calls', 'logprobs': None}, id='run-7f05e19e-4561-40e2-a2d0-8f4e28e9a00f-0', tool_calls=[{'name': 'multiply', 'args': {'a': 3, 'b': 12}, 'id': 'call_BwYJ4UgU5pRVCBOUmiu7NhF9', 'type': 'tool_call'}], usage_metadata={'input_tokens': 80, 'output_tokens': 17, 'total_tokens': 97})

如我们所见,我们的 LLM 生成了工具的参数!您可以查看 bind_tools() 的文档,了解自定义 LLM 如何选择工具的所有方法,以及 此关于如何强制 LLM 调用工具 而不是让它自行决定的指南。

工具调用

如果工具调用包含在 LLM 响应中,则将其作为 消息 或 消息块 中的 工具调用 对象列表附加到相应的 .tool_calls 属性。

请注意,聊天模型可以同时调用多个工具。

ToolCall 是一个类型化的字典,其中包含工具名称、参数值的字典以及(可选)标识符。没有工具调用的消息将为此属性默认为空列表。

query = "What is 3 * 12? Also, what is 11 + 49?"

llm_with_tools.invoke(query).tool_calls

[{'name': 'multiply',

'args': {'a': 3, 'b': 12},

'id': 'call_rcdMie7E89Xx06lEKKxJyB5N',

'type': 'tool_call'},

{'name': 'add',

'args': {'a': 11, 'b': 49},

'id': 'call_nheGN8yfvSJsnIuGZaXihou3',

'type': 'tool_call'}]

.tool_calls 属性应包含有效的工具调用。请注意,有时模型提供程序可能会输出格式错误的工具调用(例如,无效的 JSON 参数)。在这些情况下,解析失败时,.invalid_tool_calls 属性中将填充 InvalidToolCall 的实例。InvalidToolCall 可以具有名称、字符串参数、标识符和错误消息。

解析

如果需要,输出解析器 可以进一步处理输出。例如,我们可以使用 PydanticToolsParser 将 .tool_calls 上填充的现有值转换为 Pydantic 对象。

from langchain_core.output_parsers import PydanticToolsParser

from langchain_core.pydantic_v1 import BaseModel, Field

class add(BaseModel):

"""Add two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

class multiply(BaseModel):

"""Multiply two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

chain = llm_with_tools | PydanticToolsParser(tools=[add, multiply])

chain.invoke(query)

[multiply(a=3, b=12), add(a=11, b=49)]

后续步骤

现在您已经了解了如何将工具模式绑定到聊天模型并让模型调用工具。

接下来,查看本指南,了解如何通过调用函数并将结果传回模型来实际使用工具。

- 将 工具结果传回模型

您还可以查看工具调用的更多具体用法。