检索增强生成 (RAG)

先决条件

概述

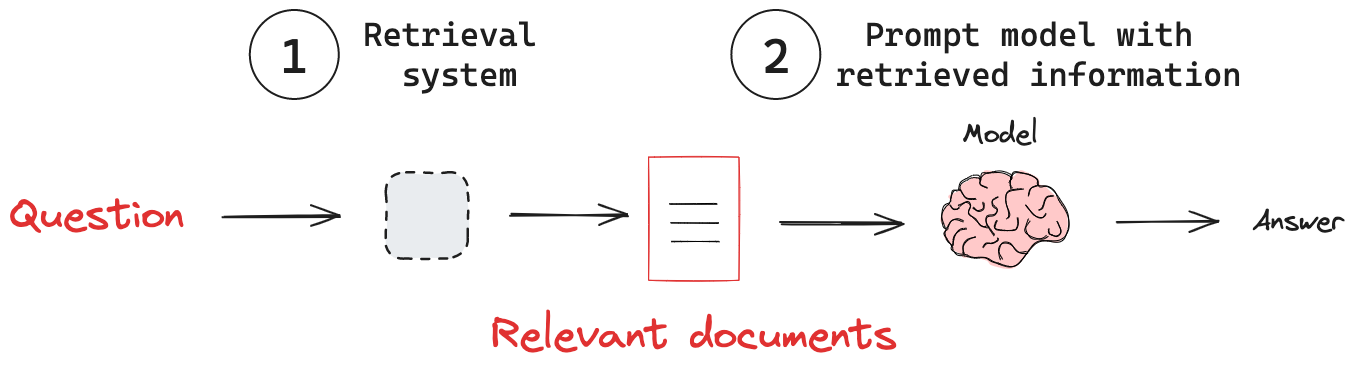

检索增强生成(RAG)是一种强大的技术,可以通过将其与外部知识库结合来增强语言模型。RAG 解决了模型的一个关键限制:模型依赖固定的训练数据集,这可能导致信息过时或不完整。当给定一个查询时,RAG 系统首先会在知识库中搜索相关信息。然后,系统将检索到的信息整合到模型的提示中。模型利用提供的上下文来生成对查询的响应。通过弥合庞大语言模型与动态、有针对性的信息检索之间的鸿沟,RAG 是一种构建更强大、更可靠的 AI 系统的强大技术。

关键概念

(1) 检索系统:从知识库中检索相关信息。

(2) 添加外部知识:将检索到的信息传递给模型。

检索系统

模型的内部知识通常是固定的,或者由于高昂的训练成本而无法频繁更新。这限制了它们回答时事问题或提供特定领域知识的能力。为了解决这个问题,有各种知识注入技术,例如微调或持续预训练。两者都成本高昂,并且通常不适合事实检索。使用检索系统具有以下几个优点:

- 最新信息:RAG 可以访问并利用最新数据,保持响应的时效性。

- 领域专业知识:通过特定领域的知识库,RAG 可以在特定领域提供答案。

- 减少幻觉:将响应建立在检索到的事实之上,有助于最大程度地减少虚假或捏造的信息。

- 经济高效的知识集成:RAG 提供了一种比昂贵的模型微调更高效的替代方案。

延伸阅读

请参阅我们的概念指南:检索。

添加外部知识

有了检索系统,我们需要将该系统中的知识传递给模型。RAG 管道通常通过以下步骤实现这一点:

- 接收输入查询。

- 使用检索系统根据查询搜索相关信息。

- 将检索到的信息整合到发送给 LLM 的提示中。

- 生成利用检索上下文的响应。

例如,这是一个简单的 RAG 工作流,它将信息从一个检索器传递给一个聊天模型

from langchain_openai import ChatOpenAI

from langchain_core.messages import SystemMessage, HumanMessage

# Define a system prompt that tells the model how to use the retrieved context

system_prompt = """You are an assistant for question-answering tasks.

Use the following pieces of retrieved context to answer the question.

If you don't know the answer, just say that you don't know.

Use three sentences maximum and keep the answer concise.

Context: {context}:"""

# Define a question

question = """What are the main components of an LLM-powered autonomous agent system?"""

# Retrieve relevant documents

docs = retriever.invoke(question)

# Combine the documents into a single string

docs_text = "".join(d.page_content for d in docs)

# Populate the system prompt with the retrieved context

system_prompt_fmt = system_prompt.format(context=docs_text)

# Create a model

model = ChatOpenAI(model="gpt-4o", temperature=0)

# Generate a response

questions = model.invoke([SystemMessage(content=system_prompt_fmt),

HumanMessage(content=question)])