如何使用聊天模型调用工具

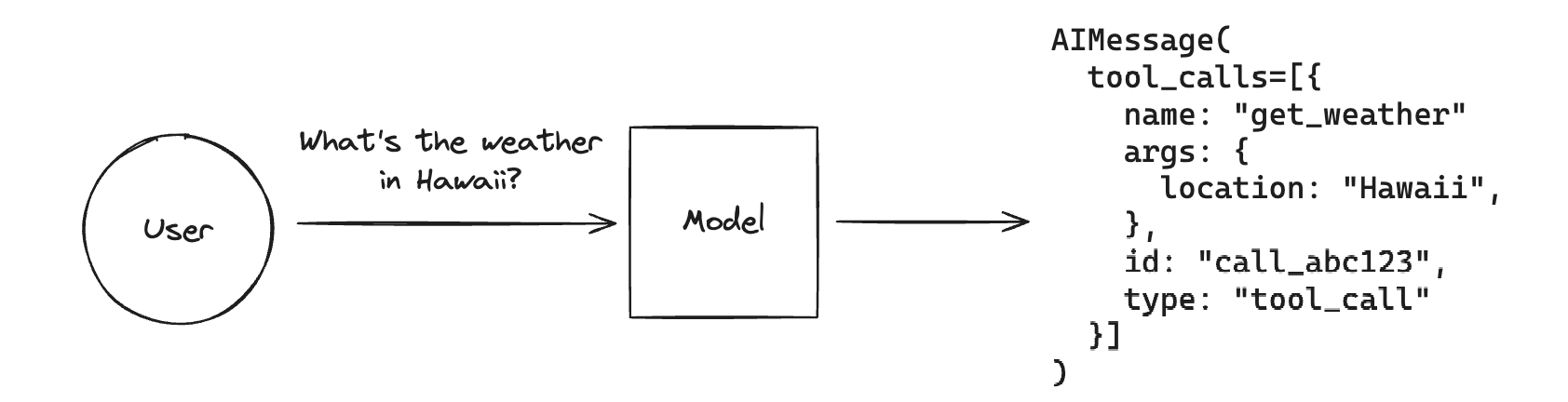

工具调用 允许聊天模型通过“调用工具”来响应给定的提示。

请记住,虽然“工具调用”这个名称暗示模型正在直接执行某些操作,但实际情况并非如此!模型仅生成工具的参数,而实际运行(或不运行)工具则取决于用户。

工具调用 是一种通用技术,可以从模型生成结构化输出,即使您不打算调用任何工具,也可以使用它。一个示例用例是 从非结构化文本中提取信息。

如果您想了解如何使用模型生成的工具调用来实际运行工具 请查看本指南。

工具调用并非通用,但受到许多流行的 LLM 提供商的支持。您可以在此处找到 所有支持工具调用的模型列表。

LangChain 实现了定义工具、将工具传递给 LLM 以及表示工具调用的标准接口。本指南将介绍如何将工具绑定到 LLM,然后调用 LLM 以生成这些参数。

定义工具模式

为了使模型能够调用工具,我们需要传入描述工具功能及其参数的工具模式。支持工具调用功能的聊天模型实现了 `.bind_tools()` 方法,用于将工具模式传递给模型。工具模式可以作为 Python 函数(带有类型提示和文档字符串)、Pydantic 模型、TypedDict 类或 LangChain Tool 对象传入。模型后续的调用将与提示一起传入这些工具模式。

Python 函数

我们的工具模式可以是 Python 函数

# The function name, type hints, and docstring are all part of the tool

# schema that's passed to the model. Defining good, descriptive schemas

# is an extension of prompt engineering and is an important part of

# getting models to perform well.

def add(a: int, b: int) -> int:

"""Add two integers.

Args:

a: First integer

b: Second integer

"""

return a + b

def multiply(a: int, b: int) -> int:

"""Multiply two integers.

Args:

a: First integer

b: Second integer

"""

return a * b

LangChain 工具

LangChain 还实现了一个 `@tool` 装饰器,允许进一步控制工具模式,例如工具名称和参数描述。有关详细信息,请参阅 此处的 操作指南。

Pydantic 类

您可以使用 Pydantic,无需附带函数即可等效地定义模式。

请注意,除非提供默认值,否则所有字段都是 `required`(必需的)。

from pydantic import BaseModel, Field

class add(BaseModel):

"""Add two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

class multiply(BaseModel):

"""Multiply two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

TypedDict 类

或者使用 TypedDicts 和注解

from typing_extensions import Annotated, TypedDict

class add(TypedDict):

"""Add two integers."""

# Annotations must have the type and can optionally include a default value and description (in that order).

a: Annotated[int, ..., "First integer"]

b: Annotated[int, ..., "Second integer"]

class multiply(TypedDict):

"""Multiply two integers."""

a: Annotated[int, ..., "First integer"]

b: Annotated[int, ..., "Second integer"]

tools = [add, multiply]

要将这些模式实际绑定到聊天模型,我们将使用 `.bind_tools()` 方法。这会处理将 `add` 和 `multiply` 模式转换为模型所需的正确格式。每次调用模型时,都会传入工具模式。

pip install -qU "langchain[google-genai]"

import getpass

import os

if not os.environ.get("GOOGLE_API_KEY"):

os.environ["GOOGLE_API_KEY"] = getpass.getpass("Enter API key for Google Gemini: ")

from langchain.chat_models import init_chat_model

llm = init_chat_model("gemini-2.0-flash", model_provider="google_genai")

llm_with_tools = llm.bind_tools(tools)

query = "What is 3 * 12?"

llm_with_tools.invoke(query)

AIMessage(content='', additional_kwargs={'tool_calls': [{'id': 'call_iXj4DiW1p7WLjTAQMRO0jxMs', 'function': {'arguments': '{"a":3,"b":12}', 'name': 'multiply'}, 'type': 'function'}], 'refusal': None}, response_metadata={'token_usage': {'completion_tokens': 17, 'prompt_tokens': 80, 'total_tokens': 97}, 'model_name': 'gpt-4o-mini-2024-07-18', 'system_fingerprint': 'fp_483d39d857', 'finish_reason': 'tool_calls', 'logprobs': None}, id='run-0b620986-3f62-4df7-9ba3-4595089f9ad4-0', tool_calls=[{'name': 'multiply', 'args': {'a': 3, 'b': 12}, 'id': 'call_iXj4DiW1p7WLjTAQMRO0jxMs', 'type': 'tool_call'}], usage_metadata={'input_tokens': 80, 'output_tokens': 17, 'total_tokens': 97})

正如我们所见,我们的 LLM 为工具生成了参数!您可以查阅 bind_tools() 的文档,了解如何自定义 LLM 选择工具的所有方式,以及这篇 关于如何强制 LLM 调用工具而不是让其自行决定的指南。

工具调用

如果 LLM 响应中包含工具调用,它们会作为工具调用对象列表,附加到相应的 消息 或 消息块 的 `.tool_calls` 属性中。

请注意,聊天模型可以同时调用多个工具。

一个 `ToolCall` 是一个类型化的字典,包含工具名称、参数值字典以及(可选的)标识符。没有工具调用的消息,此属性默认为空列表。

query = "What is 3 * 12? Also, what is 11 + 49?"

llm_with_tools.invoke(query).tool_calls

[{'name': 'multiply',

'args': {'a': 3, 'b': 12},

'id': 'call_1fyhJAbJHuKQe6n0PacubGsL',

'type': 'tool_call'},

{'name': 'add',

'args': {'a': 11, 'b': 49},

'id': 'call_fc2jVkKzwuPWyU7kS9qn1hyG',

'type': 'tool_call'}]

`.tool_calls` 属性应包含有效的工具调用。请注意,有时模型提供商可能会输出格式错误的工具调用(例如,参数不是有效的 JSON)。当这些情况下的解析失败时,InvalidToolCall 实例会填充到 `.invalid_tool_calls` 属性中。一个 `InvalidToolCall` 可以包含名称、字符串参数、标识符和错误消息。

解析

如果需要,输出解析器 可以进一步处理输出。例如,我们可以使用 PydanticToolsParser 将 `.tool_calls` 上已填充的现有值转换为 Pydantic 对象

from langchain_core.output_parsers import PydanticToolsParser

from pydantic import BaseModel, Field

class add(BaseModel):

"""Add two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

class multiply(BaseModel):

"""Multiply two integers."""

a: int = Field(..., description="First integer")

b: int = Field(..., description="Second integer")

chain = llm_with_tools | PydanticToolsParser(tools=[add, multiply])

chain.invoke(query)

[multiply(a=3, b=12), add(a=11, b=49)]

下一步

现在,您已了解如何将工具模式绑定到聊天模型并让模型调用工具。

接下来,请查看本指南,了解如何通过调用函数并将结果传回模型来实际使用工具

- 将 工具结果传回模型

你还可以查看工具调用的其他一些特定用法